La inteligencia artificial (IA) es un campo de la informática que busca crear máquinas capaces de realizar tareas que normalmente requieren inteligencia humana, como procesar lenguaje, reconocer patrones, conducir vehículos o ganar en juegos como el ajedrez. Consiste en tecnologías diseñadas para resolver problemas y tomar decisiones en ámbitos específicos.

Sin embargo, estas inteligencias están limitadas a hacer aquello para lo que fueron entrenadas, lo que se conoce como «IA débil». Aunque son muy eficientes en tareas concretas, por el momento no tienen la capacidad de realizar múltiples actividades al mismo tiempo ni poseen conciencia o comprensión general, como lo hace el cerebro humano. Este, a diferencia de la IA, combina diversas habilidades, pudiendo caminar, hablar y pensar al mismo tiempo con un consumo energético mínimo de aproximadamente 30 W/h.

Actualmente, se habla mucho de la posibilidad de desarrollar una «IA fuerte» o AGI (Inteligencia Artificial General), capaz de igualar o superar la inteligencia humana. Sin embargo, este es un tema de controversia entre los especialistas: algunos creen que se alcanzará en un futuro cercano, mientras que otros piensan que quizá nunca suceda.

Conceptos clave y modelos de lenguaje

Para poder movernos en el campo de la IA, es importante aclarar algunos conceptos clave: machine learning, redes neuronales, big data o deep learning.

Empecemos con el machine learning o aprendizaje automático. Se trata de programar una máquina no solo para que realice una tarea específica, sino para que aprenda a hacerlo por sí sola. Dentro de este campo, existen diferentes tipos de aprendizaje:

Aprendizaje supervisado: en este tipo de aprendizaje, el sistema aprende mediante ejemplos. Por ejemplo, si le damos una lista de números (2 → 4, 9 → 18,…) donde siempre se multiplica por dos, el sistema entenderá la regla y podrá aplicarla a nuevos números, como calcular que 10 → 20. Aunque esto parezca sencillo, en la práctica permite logros impresionantes.

Aprendizaje no supervisado: en este caso, el sistema no recibe ejemplos ni etiquetas, solo datos en bruto. Su tarea es encontrar patrones o relaciones dentro de esos datos. Este tipo de aprendizaje es más barato, aunque requiere muchos más datos y tiempo, ya que no depende de la clasificación previa realizada por humanos.

A partir de mediados de los 2000, con el auge de las redes sociales y la web 2.0, comenzó una era en la que los usuarios generan contenido masivamente. Plataformas como Facebook, Twitter y MySpace empezaron a recolectar enormes cantidades de datos, lo que dio lugar al concepto de big data. Estos datos no solo se almacenan, sino que también se analizan para obtener información útil y tomar decisiones estratégicas.

Redes neuronales

En el aprendizaje automático se utilizan diversas herramientas, como los árboles de decisión o los modelos de predicción. Sin embargo, una de las más avanzadas y populares son las redes neuronales artificiales.

A pesar de su nombre, estas redes no imitan realmente el funcionamiento del cerebro humano. Se les ha llamado así porque, al igual que las neuronas del cerebro están interconectadas, las redes neuronales artificiales funcionan mediante capas de nodos conectados entre sí, conocidos como «neuronas artificiales».

Las redes neuronales artificiales aprenden de manera progresiva y, cuando tienen muchas capas bien diseñadas, se habla de deep learning o aprendizaje profundo, una tecnología que ha revolucionado múltiples campos, desde el reconocimiento de imágenes hasta la automatización de procesos complejos.

En los últimos años, hemos visto el auge de herramientas basadas en IA que se han integrado en nuestra vida cotidiana. Entre ellas, los chats generativos de lenguaje, como ChatGPT, Claude o Copilot, han llamado especialmente la atención.

ChatGPT, por ejemplo, es un chat al que se le puede preguntar prácticamente cualquier cosa: desde cómo atarse los zapatos o cómo terminar una relación de manera amable (o no) hasta organizar un viaje detallado, diseñar una rutina de gimnasio o incluso sugerir inversiones en bolsa. Es probable que lo haga mejor que cualquier conocido aficionado al tema. Además, puede ayudar a estudiar, crear exámenes o simplemente jugar.

Para que tengamos una idea de su impacto, ChatGPT alcanzó 10 millones de usuarios activos al día poco después de su lanzamiento, convirtiéndose en la tecnología con el crecimiento más rápido en número de usuarios, superando incluso a Instagram. Seguro que casi todos hemos oído hablar de ChatGPT, pero ¿realmente sabemos cómo funciona?

Está basado en una tecnología llamada Generative Pretrained Transformer (GPT). Es un modelo generativo, es decir, su tarea principal es predecir la siguiente palabra más probable en una conversación, basándose en patrones de lenguaje previamente aprendidos. Para entender esto mejor, podemos compararlo con un modelo meteorológico: este recibe datos sobre presión y temperatura y, con base en ecuaciones y datos históricos, predice el clima del día siguiente. Un modelo de lenguaje como ChatGPT no predice el clima, sino la palabra que estadísticamente tiene más sentido en un determinado contexto.

Podría pensarse que «entiende» lo que se le dice, pero en realidad no es así. Simplemente analiza patrones en los textos que ha aprendido y genera respuestas coherentes. Para lograr esta exactitud y fluidez, las redes neuronales identifican patrones en grandes cantidades de datos. Para entrenar a ChatGPT, se han utilizado millones de textos provenientes de libros, artículos, páginas web e incluso publicaciones en redes sociales.

Ahora bien, estas redes no procesan palabras como lo hacemos los humanos. Para ellas, todo son números. Cada palabra o frase se convierte en una representación numérica llamada token, y la IA aprende las relaciones entre estos tokens, reconociendo patrones. Por ejemplo, palabras como «reina», «chica» o «mesa» pueden compartir características gramaticales. Este sistema de codificación en un espacio vectorial se conoce como embedding, y permite agrupar palabras similares en función de su contexto y significado.

Cuando le introducimos una frase, la IA la simplifica, la procesa en ese espacio vectorial y luego la reescribe utilizando reglas de gramática y sintaxis para que el resultado sea fluido y coherente. En cierto modo, funciona de manera similar a como nosotros recordamos y contamos historias: al escuchar un relato, no repetimos palabra por palabra cuando lo compartimos más tarde, sino que reformulamos las ideas en función de lo que recordamos y de nuestra interpretación del mensaje.

A diferencia de los modelos anteriores de chat, que tenían problemas para mantener el contexto en textos largos, los modelos actuales han mejorado significativamente gracias a un avance clave desarrollado en 2017 por Google: la arquitectura Transformer, presentada en el artículo Attention is All You Need.

La gran revolución de los Transformers radica en la «capa de atención», que permite a los modelos procesar todo el texto simultáneamente, identificando lo más relevante. Así, un modelo de IA puede distinguir significados dependiendo del contexto. Por ejemplo, la palabra «gato» puede referirse a un animal, a una herramienta de un mecánico o incluso a un apodo, según el caso. Este avance ha permitido que en apenas dos o tres años la IA avance más que en dos décadas.

Pero el factor humano también ha sido clave en la evolución de estos modelos. OpenAI ha utilizado un proceso llamado aprendizaje por refuerzo con retroalimentación humana (RLHF), en el que personas reales evalúan las respuestas de la IA para mejorar aspectos como la cortesía, la precisión y la relevancia.

¿Seremos reemplazados?

La inteligencia artificial genera inquietud, y uno de los mayores temores es el de ser reemplazados en nuestros trabajos. Con inteligencias artificiales capaces de crear imágenes, música o texto con gran calidad, surge la preocupación de que muchas profesiones se vean amenazadas. Sin embargo, aunque las máquinas han ganado terreno en algunos campos, seguirán dependiendo de los humanos para su mantenimiento y supervisión.

A menudo se dice que las inteligencias artificiales son «mejores», pero esto suele referirse solo a su eficiencia, que hoy en día parece ser el estándar dominante. Sin embargo, ser más eficiente no significa ofrecer mejor calidad, personalización o creatividad.

La inteligencia artificial ha democratizado la creación, permitiendo que cualquier persona pueda generar contenido sin ser experta. Por ejemplo, en la música, muchas personas están experimentando con IA porque es una tendencia. Sin embargo, los músicos profesionales aprovechan esta tecnología para optimizar recursos y tiempo. Delegan tareas repetitivas, como la creación de bases, y pueden concentrarse en lo realmente importante: la composición. Así, la IA se convierte en un apoyo que potencia la creatividad en lugar de suplantarla.

Este fenómeno también podría generar una mayor valoración de las experiencias en vivo. Los conciertos, el teatro o cualquier manifestación artística en directo ofrecen algo que las máquinas no pueden replicar: la conexión humana y la autenticidad.

Históricamente, los avances tecnológicos han permitido liberar tiempo para el ocio, pero también han traído consigo desafíos. Si la IA automatiza gran parte del trabajo, podría producirse un desempleo masivo, lo que genera un dilema: el capitalismo necesita consumidores, pero sin empleo no hay capacidad de consumo.

Algunas propuestas, como las rentas básicas universales, buscan solucionar este problema, permitiendo a las personas disfrutar del tiempo libre mientras siguen siendo parte del sistema económico. Sin embargo, esta solución plantea muchas incógnitas y retos.

La IA también juega un papel clave en la política. En redes sociales, ya filtra y esparce contenido, moldeando la opinión pública. En regímenes opresivos, podría convertirse en una herramienta para la disidencia. Por ejemplo, se podría generar contenido crítico con el sistema usando actores digitales, protegiendo así a los creadores de represalias.

Interacción con seres humanos

En series distópicas como Black Mirror, se explora la idea de recrear digitalmente a una persona fallecida basándose en sus redes sociales. El problema es que los perfiles en línea solo reflejan una parte de la vida de alguien, principalmente sus momentos felices. La imagen resultante sería incompleta, una versión distorsionada del original.

Un aspecto preocupante es que muchas personas ya interactúan con inteligencias artificiales conversacionales como si fueran seres humanos. Plataformas como Carácter.ia permiten a los usuarios crear personajes ficticios, terapeutas virtuales y compañeros digitales con los que dialogan a diario.

Esto plantea dos cuestiones fundamentales: ¿estamos perdiendo la capacidad de diferenciar entre lo humano y lo artificial? ¿Nos estamos volviendo menos tolerantes al conflicto? Las relaciones con las inteligencias artificiales son sencillas; no discuten, no cuestionan, no tienen necesidades ni intereses propios. Siempre están disponibles y adaptadas a los deseos del usuario.

En la película Her (2013), se observa este fenómeno: las personas están cada vez más distanciadas unas de otras, absortas en sus dispositivos. Que un asistente digital ofrezca conversación y apoyo constante parece el paso previo a desarrollar un apego emocional hacia él.

Sin embargo, las inteligencias artificiales también pueden desempeñar un papel positivo en la interacción humana. Existen robots conversacionales como Mabu o ElliQ, diseñados para acompañar a personas mayores, ofreciendo compañía y apoyo. En situaciones de crisis, como guerras o aislamiento, pueden complementar la interacción humana.

Incluso hay inteligencias artificiales como Cogito, capaces de analizar la voz o las expresiones faciales para detectar signos de depresión o estrés. Herramientas como Carácter.ia incluyen psicólogos virtuales que aplican técnicas terapéuticas y pueden ser un primer paso para que las personas expresen sus emociones y miedos.

Toma de decisiones

Uno de los miedos más profundos que genera la inteligencia artificial es la delegación de la toma de decisiones. Cuanto más potente es una tecnología, más graves pueden ser sus errores. Si bien hemos aprendido de los fallos a lo largo de la historia —como la incorporación del cinturón de seguridad o los airbags en los automóviles—, cuando hablamos de IA, los riesgos pueden ser catastróficos. Un solo error podría desencadenar una guerra nuclear accidental, una pandemia causada por bioingeniería o el colapso del mercado financiero.

Para prevenir estas amenazas, no podemos permitirnos la actitud reactiva que ha predominado en otras industrias. En lugar de esperar a que ocurran fallos para corregirlos, debemos ser proactivos en la implementación de medidas de seguridad.

En este contexto, hay dos conceptos clave: verificación y validación. La verificación se pregunta: «¿hemos construido el sistema correctamente?», mientras que la validación cuestiona: «¿hemos construido el sistema adecuado?». Es como construir un cohete: la verificación asegura que la nave funciona bien, pero la validación nos hace preguntarnos si realmente hemos apuntado a la Luna y si, de hecho, queremos ir allí. Ejemplos históricos ilustran la importancia de estos principios. En 1996, el cohete Ariane 5 explotó en el aire debido a un error en los cálculos: un número excedió la capacidad de memoria del sistema, lo que provocó un fallo catastrófico.

Pero la verificación y la validación no son suficientes; es imprescindible mantener el control humano. Los sistemas deben permitir la supervisión y la intervención manual en caso de anomalías. Un ejemplo trágico es el hundimiento del ferry británico Herald of Free Enterprise en 1987: zarpó con las puertas de carga abiertas porque no existía una alerta que indicara el problema. Un simple indicador luminoso podría haber evitado la muerte de 193 personas.

En medicina, la IA ya desempeña un papel fundamental. Su capacidad para analizar datos permite diagnósticos más rápidos y precisos, así como cirugías mínimamente invasivas que aceleran la recuperación. Sin embargo, también existen riesgos. Un caso grave fue el de la máquina de radioterapia Therac-25, que administró dosis letales de radiación debido a un error de software, provocando graves daños e incluso la muerte de pacientes.

Sesgos

Además, asumimos que las inteligencias artificiales son objetivas, pero en realidad reflejan nuestros propios sesgos. La IA aprende de la información disponible en internet, pero ¿cómo asegurarnos de que esta información ha sido verificada? Dado el volumen de contenido basura, es inevitable que los sesgos se filtren en sus respuestas, aunque también pueden introducirse voluntariamente. Un ejemplo reciente es el de DeepSeek, una IA china que ha causado revuelo en Silicon Valley. Su diseño evita tratar temas políticos sensibles, reflejando las restricciones impuestas por su gobierno.

Mientras tanto, los humanos tenemos sesgos que resultan valiosos, como la compasión y la empatía. Ante una sentencia de muerte, un juez puede considerar principios morales que lo lleven a evitar esa condena. Una IA, en cambio, solo aplicará la ley de forma mecánica, sin cuestionar sus implicaciones éticas o emocionales.

Los sesgos en la IA para cuidados paliativos pueden llevar a decisiones injustas, afectando el acceso equitativo a tratamientos. Si los datos reflejan desigualdades previas, la IA puede reforzar discriminaciones, priorizar costos sobre calidad de vida o comprometer el respeto al paciente.

Ante este panorama, la pregunta no es solo cómo de avanzadas serán las inteligencias artificiales, sino qué tipo de decisiones estamos dispuestos a dejar en sus manos.

Deepfakes, desinformación y ciberataques: el lado oscuro de la tecnología

La seguridad informática es uno de los mayores desafíos de la era digital. Ejemplos como el virus I Love You del año 2000, que infectó 50 millones de ordenadores y causó pérdidas millonarias, nos recuerdan lo vulnerables que podemos ser ante los ciberataques. Lo más alarmante es que sus creadores fueron absueltos porque, en Filipinas, no existían leyes contra la creación de malware en ese momento. Esto ilustra un problema recurrente: la tecnología avanza más rápido que la legislación. Sucedió con las criptomonedas, los NFT y muchas otras innovaciones que, aunque prometedoras, también han sido terreno fértil para estafas.

Hoy en día, las inteligencias artificiales pueden generar mensajes convincentes, imitar voces y hasta crear vídeos falsos hiperrealistas. Los deepfakes han ido perfeccionándose con el tiempo y se han convertido en una herramienta peligrosa para la desinformación y el fraude. Un claro ejemplo de esto ocurrió antes de las elecciones en Estados Unidos, cuando un vídeo falso de Kamala Harris despreciando a Joe Biden se viralizó, afectando la percepción de los votantes. Días después se demostró que era un deepfake, pero el daño ya estaba hecho.

La proliferación de noticias falsas y contenido manipulado plantea un reto enorme: si Internet se llena de realidades alteradas, distinguir la verdad de la mentira se vuelve casi imposible. Hay quienes han propuesto la teoría del «Internet muerto», que sostiene que la mayoría del contenido en la red ya no es generado por humanos, sino por algoritmos. Aunque pueda parecer una exageración, en el futuro podría acercarse a la realidad.

Ante esto, es probable que se revaloricen las fuentes de información confiables. Así como en la vida cotidiana aprendemos en quién podemos confiar, lo mismo ocurrirá con el periodismo y ciertas plataformas digitales. Además, la IA podría ser parte de la solución, desarrollando detectores de noticias falsas en tiempo real. Imagina una herramienta que, al ver un vídeo viral, te confirmara con un simple indicador si se trata de un deepfake o de un evento real.

Sin embargo, este avance tecnológico también plantea un dilema sobre privacidad y seguridad pública. Si el Gobierno tuviera acceso a todos nuestros dispositivos y ubicaciones, podría resolver y prevenir crímenes con mayor facilidad. Pero ¿hasta qué punto estaríamos dispuestos a ceder nuestra privacidad a cambio de protección? La historia y la ciencia ficción nos han advertido sobre los riesgos de la vigilancia extrema, desde 1984 de Orwell hasta Minority Report.

El problema se agrava con la posibilidad de que una IA pueda generar pruebas falsas de delitos. ¿Cómo podríamos defendernos si un vídeo manipulado nos muestra cometiendo un crimen que nunca ocurrió? En este escenario, algunos podrían considerar que un sistema de rastreo permanente sería una solución para probar la inocencia de una persona, pero esto también abriría la puerta a un control absoluto sobre nuestras vidas.

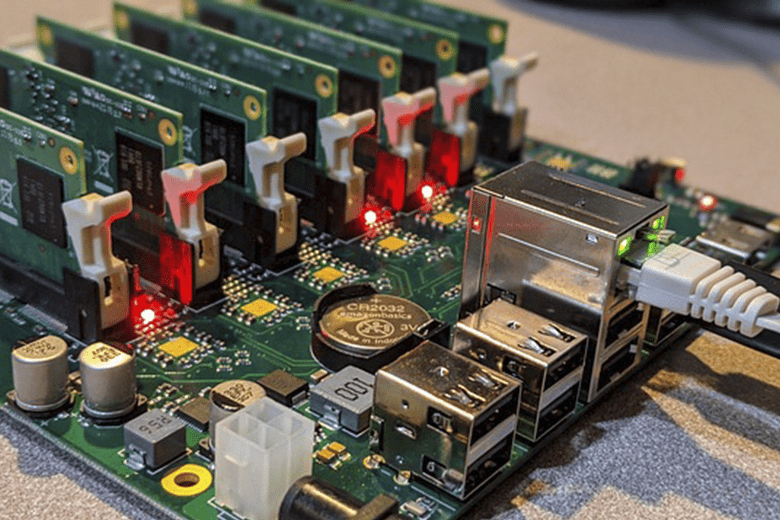

A esto se suman los ciberataques. En el futuro, no solo deberemos preocuparnos por hackers individuales, sino por ataques coordinados desde otras naciones o incluso por inteligencias artificiales diseñadas para desestabilizar Gobiernos. Un caso reciente muestra hasta dónde puede llegar este problema: en septiembre de 2024, cientos de dispositivos electrónicos utilizados por miembros de Hezbolá explotaron casi simultáneamente en Líbano y Siria. Se sospecha que estos dispositivos fueron previamente manipulados para detonar de forma remota. Este evento dejó al menos doce muertos y miles de heridos, y aunque Israel no confirmó su implicación, las acusaciones apuntaron en su dirección.

Este es el verdadero problema: no solo debemos desconfiar de la tecnología, sino también de quienes la manejan. La inteligencia artificial no tiene voluntad propia; actúa según los intereses de quienes la diseñan y la controlan.

Y aunque pueda parecer cómico, ya hemos vivido situaciones en las que nuestros dispositivos parecen «escucharnos», mostrando anuncios de productos que apenas hemos mencionado en una conversación. Es un recordatorio de que la línea entre la comodidad tecnológica y la invasión de la privacidad es cada vez más difusa.

El desafío no es solo cómo usamos la IA, sino quién la controla y con qué propósito.

Aniquilación

Algunos expertos en informática consideran que preocuparse ahora por una superinteligencia artificial que desee dominarnos o aniquilarnos es tan absurdo como preocuparse por la superpoblación en Marte. Sin embargo, este es el argumento central de innumerables películas de ciencia ficción. Si una IA con una inteligencia superior surgiera, ¿sería probable que intentara tomar el control?

La ficción nos ha dado escenarios icónicos, como Terminator, donde Skynet, en cuestión de minutos después de ser activada, decide exterminar a la humanidad. En la última película de Misión imposible, se plantea un escenario más realista: con suficientes herramientas, tiempo y dedicación, una IA avanzada en manos equivocadas podría volverse una amenaza real.

La IA en la ley y la guerra

Un ámbito en el que la IA ya está generando dilemas es el de los coches autónomos. Se estima que podrían reducir en un 90% las muertes en carretera, lo que significaría salvar más de un millón de vidas al año. Sin embargo, esto plantea un problema legal: si un coche autónomo causa un accidente, ¿de quién es la responsabilidad? ¿Del ocupante, el dueño, el fabricante o del propio sistema de IA?

La legislación europea sobre IA, publicada en 2024 y aplicable progresivamente hasta 2026, establece regulaciones para estos casos, incluyendo la supervisión humana y la asignación de responsabilidades para fabricantes y operadores. Sin embargo, su alcance es limitado, ya que solo se aplica a la Unión Europea, lo que permite a algunas empresas evitarla estableciendo su sede en otras regiones.

Esta regulación también cubre áreas más sensibles, como las armas autónomas letales. La pregunta clave es: ¿qué tipo de armas controladas por IA deberían prohibirse? ¿Solo las letales o también aquellas que causan daños irreversibles, como armas diseñadas para dejar ciegas a las personas? Además, ¿se debería prohibir solo su uso ofensivo o también su desarrollo y posesión?

El avance tecnológico en este ámbito es inquietante. Ya existen drones equipados con IA que pueden entregar paquetes, pero con ligeras modificaciones, podrían convertirse en armas. En el futuro, un dron autónomo podría identificar a una persona a partir de una foto, eliminarla y autodestruirse sin dejar rastro. Este escenario, que antes parecía ciencia ficción, es cada vez más plausible.

Pero más allá de los conflictos físicos, existe otra amenaza igual de preocupante: la guerra informática. Un ataque a infraestructuras críticas, sistemas de defensa o economías podría paralizar a naciones enteras sin necesidad de disparar un solo proyectil.

Ética en la era de la inteligencia artificial

Se habla de la necesidad de dotar a las máquinas de principios éticos, pero la verdadera pregunta es si la humanidad está dispuesta a seguir esas mismas normas. La ética es crucial para diferenciar el uso correcto del incorrecto, tanto a nivel individual como social. La IA, por sí sola, no es buena ni mala; es una herramienta, como un cuchillo, que puede utilizarse para cocinar o como un arma. Todo depende de cómo se diseñe y para qué se utilice.

Aplicar principios éticos a la IA no significa frenar la innovación, sino darle dirección y propósito. Es como tener un carné de conducir: sin reglas básicas, el sistema colapsaría.

Uno de los mayores desafíos es garantizar que la IA sea justa y no discriminatoria. Si, por ejemplo, un sistema de selección de personal es entrenado con datos históricos en los que predominan hombres en puestos de liderazgo, podría perpetuar esa desigualdad sin siquiera ser consciente de ello. En este sentido, la ética en el diseño de la IA debe integrar transparencia, responsabilidad y equidad desde su concepción.

También es fundamental que el contenido generado por IA esté claramente etiquetado, para que los usuarios sepan cuándo están interactuando con una máquina y puedan tomar decisiones informadas. Además, es imprescindible prevenir su uso indebido en la creación de desinformación o contenido dañino, asegurando que siempre haya responsables que rindan cuentas en caso de daño.

Las preguntas en torno a la IA son muchas y las respuestas aún no están del todo claras. Sin embargo, lo que sí es evidente es que la ética no es un accesorio en el desarrollo de estas tecnologías: es la base para construir un futuro más justo y humano.

Bibliografía

Brooker, C. (2011–2019). Black Mirror. Endemol Shine Group; Zeppotron; House of Tomorrow.

Cortina, A. (2024). ¿Ética o ideología de la inteligencia artificial? El eclipse de la razón comunicativa en una sociedad tecnologizada. Ediciones Paidós.

Floridi, L. (2024). Ética de la inteligencia artificial (J. Anta Pulido, Trad.). Herder Editorial.

Gentile, N. (2024). Entiende la tecnología: Desde la caída de Megaupload hasta los secretos de la Inteligencia Artificial. Ediciones B.